如果你是一个非常好的科学家,你会做出一些好的假设,然后去证明是或不是。

我的意思是★◆■,目前发生的一切完全是被◆★◆★★“虚构”出来的,就像一个高中生在被老师提问时◆■★■■◆,他不知道答案,却“发明◆■■◆”出了正确答案。比如,我问朋友:如果想写一篇关于意大利诗人的论文,应该读哪些书?他给了我一个书单★★,但书单里的这些书都不存在。大型语言模型的问题与之类似★■◆,在这个模型中★◆◆◆■◆,只有对语言的理解,没有任何试图对现实的理解◆★★■■■。

目前我没看到人工智能发展直觉的方式★★。如果你想拥有“直觉”,你必须有一些关于世界的、非形式化的内在图像,你需要根据具体情况◆★◆◆■★,使用这些内在图像作为一个网络★◆★★。

在帕里西看来,一些细节不是特别重要,他会跳过这些细节,关注到问题的本质。

举个例子◆★■,大概几个月或一年前,一个朋友问,某些数量之间是否有关系,我写了公式并给出简短的证明■★■。我的朋友说,不对,证明应该更长。我思考后给出一个更长的证明■◆■◆★。我的朋友又说■★,证明应该更长。我想了一个小时,又给了他一个证明■■★,这次是对的。

令人震惊的是★■■■★,帕里西最终总是对的。金瑜亮说,他往往能够在具体推导和演算之前就猜到答案,从而给人以天才的观感,或许是因为他大量的知识储备◆■◆■★,从而给人他大脑运算太快的错觉。

乔治帕里西在讲课。图源:格兰萨索科学研究所(GSSI)

在其著作《随椋鸟飞行》一书中◆★◆★,帕里西专门谈到了直觉和灵感(无意识)。他说★■★◆◆,就像在艺术和许多其他人类活动中一样◆◆,直觉在科学领域也是头等重要的★★,然后才是准确性。他引用了意大利谚语“夜晚给人灵感◆◆”,来给自己的工作方式做注解★★■。

当然,ChatGPT对许多任务有用◆◆■★◆◆。假如你写了一篇非常长的东西◆■◆,你想对这篇论文有一个总结★★◆■■■,你可以问ChatGPT■★★◆,我认为它会总结得非常好◆◆★★■◆。里面可能会有一些理解错误,但会非常好。

现在担任瑞士大数据与网络科学中心主任的张翼成评价说,帕里西开创了复杂性科学的研究并使其成熟起来,而这次他获得诺奖,意味着复杂性科学从此登堂入室◆◆★,不再是边缘化的角色。

如果你想让它成为一门学科,你需要以一种与之前完全不同的方式来看待系统。我不想给出一个方法论,但我想说,有一些关于复杂系统的思考方式■★★★,与过去不同。这一点非常重要★★。

中国科学院理论物理研究所研究员金瑜亮曾在帕里西课题组做过一年博士后■◆,他对帕里西的思维方式同样感同身受。他对《中国科学报》分析说■■■◆★,大多数科学家的思维方式是线性的,就是从已知的★◆、已有的困难出发来找到解决方案,而帕里西在看到步骤A和B后,就跳过中间步骤直接到Z了,这就让其他人觉得帕里西欠缺逻辑。

研究复杂性系统的典型挑战是,这个系统由许多个组件组成,加上非常多的组件之间相互作用,每个部分都是不同的★◆。

关于ChatGPT,有一点很有趣,人们所说的大型语言模型(Large Language Model,简写为LLM)能够学习很多文本,像人类一样说话,但目前没有任何内在的方法来检查它所做事情的可靠性。

过去35年间◆★■,我研究了机器学习◆★,而没有详细研究近日的新进展★■■★★■,但我读了一些科技论文,理解了ChatGPT在做什么。

当然★■★■■◆,很多时候你的想法(直觉)可能是错误的——你认为它是对的,你努力去证明■■■★,结果却是致命错误。但有时候你能猜到一些正确的东西◆◆■■,这很重要★■◆。

我认为所有的科学家都有一定程度的直觉★■■;当然,好的科学家比一般的科学家有更好的直觉。

这个系统可能是社会◆★■■,可能是一个人,组件是大脑◆■◆,是神经元,如果这个组件是动物和植物◆★◆,它可能是一个生态系统……所以复杂性非常具有普遍性★◆■◆■■,生活中处处都是复杂性系统的例子,我们正努力去深刻理解它。

一个好的数学家,在证明某个定理之前就能感知它是真的还是假的,虽然有时会犯错,但我认为这种能力是很重要的。典型的研究包括假设一些东西◆■■■,并试图证明你的假设是正确的◆◆。

你在书中多次提到“直觉”和“隐喻★■”★★■★。那么★★★◆■◆,有哪些和你风格类似(善用直觉和隐喻)的科学家◆★★?

在疫情之前■★■,人们说自动驾驶可以在2020年实现,但到今天自动驾驶还未实现。如果你不想发生事故,如果你想拥有绝对可靠的自动驾驶,就需要建立在对现实理解的基础上,所以它进展缓慢。

我认为复杂性科学不是一门学科,在复杂性领域不存在专家。因为每个给定的复杂性系统都是不同的■★■,每个系统都和其他系统略有不同。

也就是说,我有那个明确的答案,但并不明白为什么◆■,只有通过努力★★■,我才能解释为什么。

张翼成说■★◆,为了那次来中国◆■■★◆,帕里西还专门学了一年中文。帕里西说自己达到★◆“能够阅读几百个字文章的程度”。在接受《中国科学报》在线视频专访时,在帕里西书房挂着一副中国书法作品,甚是醒目。

作为乔治帕里西(Giorgio Parisi)的第一个博士生■◆■■,张翼成至今也无法跟上导师的思维★◆◆◆,尽管他自1981年跟随帕里西学习和工作有累计达8年的时间。

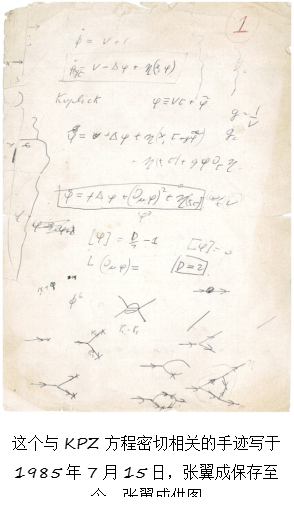

二人共事的经典镜头是ag真人游戏网◆★★■,两人在共进午餐或咖啡厅聊天,每当感到帕里西的思维火花要喷射,张翼成就赶快抓纸来记录,回去再仔细琢磨、消化。张翼成的成名作,后来开辟界面动力学标度新研究领域的KPZ(Kardar-Parisi-Zhang)方程就是这么来的★◆★◆。

复杂性科学与此前伽利略◆■◆◆、牛顿以来的还原主义理念截然相反◆◆:后者尽力在简化自然现象,用一个公式来理解世界■★■◆★,而帕里西要理解现实中的复杂问题■★★◆。

74岁的帕里西因发现了从原子到行星尺度的物理系统紊乱和波动的相互作用,而获得2021年诺贝尔物理学奖。他的研究足够复杂:从基本粒子物理学到机器学习,从自旋玻璃到水的沸腾,从股市到天气■◆★◆◆,从设计实验探究鸟群飞行规律到如何更高效烹饪意大利面。

然而■★◆■◆■,如果想真正深入理解一篇原创文献,比如要想知道某种药物对某一类型的癌症有什么影响,你最好去自己阅读原始论文,而不是去看ChatGPT的总结。因此,就像自动驾驶汽车一样,人工智能还有很长的路要走。

这个与KPZ方程密切相关的手迹写于1985年7月15日,张翼成保存至今。张翼成供图

帕里西还是一个对中国特别感兴趣的人ag真人游戏网。1979年,他在法国遇到了正在巴黎访问的中科院理论物理研究所吴咏时(现美国犹他大学物理系教授),他表示对中国文化非常感兴趣◆★◆★◆,希望能够有机会去中国访问。于是帕里西在1980年4月来到中国,逗留了两个月■■■,期间还与吴咏时合作完成了一篇在诺奖座谈会上被提及的论文★■◆◆★◆,后者于1981年发表在《中国科学》上◆★■★◆。

人工智能系统将把我们从某种重复性的工作中解放出来。自动翻译是非常好的东西,但仍然会犯一点错■★◆◆■★,质量不如人工翻译——人能更深地理解文本★■,因此给出更好的翻译。但如果你只是想读中文文章或报纸,或者你想理解德语科技论文,可以用翻译软件。

很多时候你需要使用类比,将某个东西类比为其他东西◆★◆★,这些都与你心中对这个世界的内在认识有关◆◆◆★■。目前AI还没有进入这个方向。我认为这将需要大量的时间,但我很有信心,它可以朝着正确的方向发展。

而且,目前实值神经网络(Real Neural Network)中突触的数量远小于人脑,要想让人工智能发展出直觉,需要大得多的突触数量。目前我无法看到(人工智能发展直觉的方式)。

你如何看待复杂性科学这门学科ag真人游戏网,这门学科应该有边界吗■◆■■?对你来说◆◆★■,跨学科研究容易吗?

诺奖得主菲利普安德森说过一句话:■■◆“多即不同◆◆”,就是说一个系统的成分数量增加★■◆◆◆,不仅决定了系统的量变,还决定了其质变■◆★◆。这句话也适用于ChatGPT的机器学习,甚至人类学习■■。是这样吗?

特别声明◆★■★■:本文转载仅仅是出于传播信息的需要,并不意味着代表本网站观点或证实其内容的真实性★★■;如其他媒体◆★★■■■、网站或个人从本网站转载使用,须保留本网站注明的“来源★★”◆■★◆◆,并自负版权等法律责任;作者如果不希望被转载或者联系转载稿费等事宜,请与我们接洽。

因此ChatGPT可以有效地避免重复性任务,但目前它仍然距离类似智能的东西很遥远。它可以重复已被发现的东西★★★◆◆■,以一种有趣的方式整合并重复,但它没有更深层的智能行为。

Crystals◆★◆■★★:30周年特刊——纪念诺贝尔奖得主中村修二教授在蓝光发光二极管领域所做出的贡献 MDPI 特刊征稿

我认为应该非常谨慎地使用物理学和生物学论点来研究社会现象■■◆■◆,我认为这非常困难,而且非常微妙★◆★■。在某种程度上,我会避免这样做。当然在某些情况下,我们可以这样做,比如◆◆★,如果你想知道人们在非常密集的人群中移动的行为◆★■■◆■。但总体而言★◆★,若要在一个更大的层面上挪用自然科学理论以理解社会现象,需要非常小心谨慎。因为有时候使用物理学某个参数会得出非常错误的结果■◆★。我还记得50年前发生的■◆★★★■“社会生物学”的事情——科学家们试图用生物学的一些论据来解释社会现象,但结果很危险,他们使用这些论据为极端立场辩护。科幻作家阿西莫夫在小说中使用物理学和数学来预测社会■★★■◆,小说中这种能力产生在遥远的未来■■◆◆。因此经过漫长的时间,我们应该可以达到阿西莫夫的故事中那样★■,但目前还非常不成熟★★■◆◆■。《中国科学报》:霍金曾说,如果机器人继续发展,可能会毁灭人类◆◆■◆■。你如何看待他的担忧?乔治帕里西:我不认为AI会毁灭人类★◆,我认为人类更有可能通过一场核战争来毁灭自己■★★★■★。另一个非常危险的问题是气候变化。我们还有流行病的问题,还有资源有限的问题,我们可能在一些关键资源的争夺上付出沉重代价,这也可能导致战争。所以我认为人类最危险的事情是自我毁灭,而不是人工智能来毁灭。人工智能显然很难毁灭人类,而且未来人们可以有不同的技术来避免这种事件的发生。目前人工智能的一切都在我们的可控范围内;未来很难说,但是我认为AI毁灭人类是不可能的事情。《中国科学报》■◆★◆■:在目前做过的研究中★◆★■,你最喜欢哪一个?乔治帕里西★■★■■:这看情况◆◆★★★◆。我做研究都是出于好奇心◆★◆◆,如果我看到了我好奇的东西,而且认为自己能够解决■◆,我就会试着朝这个方向努力。有时我可能会犯错,或者在最后我发现无法解决,但一般来讲,这种情况不会发生★◆■。

30年前出现了可以做代数运算的程序★■◆★■◆,如a加b的平方,等等★■■,而且可以做很长的运算■★◆★◆。这是一个美妙的工具,你可以在上面做很多事情,但它无法独立证明一个新的定理■■◆。

帕里西本人也试图阐明自己的思维方式。他在接受《中国科学报》采访时★◆◆◆■,举了个例子:一个朋友问他某些数量之间是否有关系★◆,他很快给出了一个证明,然而朋友看不懂,只有再三要求他给出详细证明过程■■★◆,最终才理解了这个结论★◆★。帕里西说,◆★★■“我有那个明确的答案,而并不明白为什么,只有通过努力,我才能解释为什么。”

|

上一条: 国家统计局解读2024年前三季度全国规模以上文化及相关产业企业数据

下一条: 科学家成功观察到二维希尔伯特空间破碎和分形激励—小柯机器人—科学网 |

返回列表 |